近日,ICASSP 2022会议发出了审稿结果通知,语音及语言信息处理国家工程研究中心智能语音信息处理团队共15篇论文被会议接收,论文方向涵盖语音识别、语音合成、话者识别、语音增强、情感识别、病理语音评估、声音事件检测、自然语言理解等,各接收论文简介见后文。

ICASSP(International Conference on Acoustics, Speech, and Signal Processing)是IEEE信号处理学会(Signal Processing Society)的学术年会,是全世界规模最大、最全面的声学、语音和信号处理及其应用方面的国际会议,也是语音技术领域最具影响力的顶级国际会议。

语音及语言信息处理国家工程实验室于2011年由国家发改委正式批准成立,由中国科学技术大学和科大讯飞股份有限公司联合共建,是我国语音产业界唯一的国家级研究开发平台。2021年底,实验室通过国家发改委的优化整合评估,成功纳入新序列,并转建为语音及语言信息处理国家工程中心。

1. A Noise-Robust Self-supervised Pre-training Model Based Speech Representation Learning for Automatic Speech Recognition

论文作者:朱秋实,张结,张自强,吴明辉,方昕,戴礼荣

论文单位:中国科学技术大学,科大讯飞,中科院声学所国家重点实验室

论文简介:

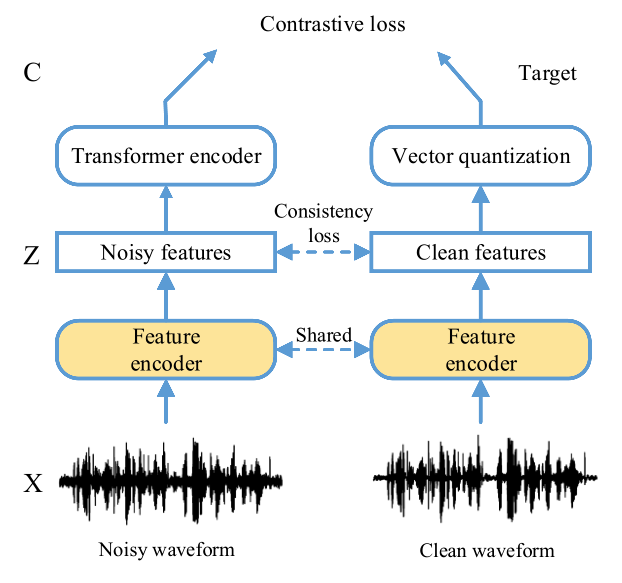

Wav2vec2.0是一个流行的自监督预训练框架,用于在语音识别任务中学习上下文的表征。现有的结果表明wav2vec2.0对领域迁移有较好的鲁棒性,而对噪声的鲁棒性仍然不清楚。因此,在这项工作中,我们首先通过实验分析wav2vec2.0的噪声鲁棒性。我们观察到带噪数据进行预训练的wav2vec2.0模型可以获得较好的表征,从而提高了在带噪测试集上语音识别的性能,但是在干净测试集上带来了性能下降。为了避免这个问题,我们提出了enhanced wav2vec2.0,具体来说,带噪语音和对应的干净语音经过同一个特征提取器,其中量化之后的干净语音为模型提供训练目标。实验结果表明,该方法不仅可以提高模型在带噪语音上的性能,超过原始的wav2vec2.0,而且,可以确保在干净测试集上的性能下降较小。此外,在不同类型的噪声条件下验证了方法的有效性。

论文资源:论文预印版下载地址https://arxiv.org/abs/2201.08930(或扫描下方二维码)

2. Reference Microphone Selection and Low-rank Approximation based Multichannel Wiener Filter with Application to Speech Recognition

论文作者:陈星宇,张结,戴礼荣

论文单位:中国科学技术大学,中国科学院声学研究所声场声信息国家重点实验室

论文简介:

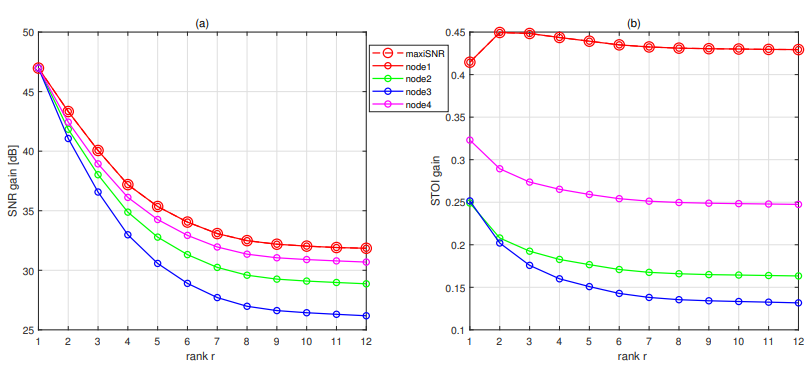

对于多通道语音识别系统,有必要使用语音增强模块来抑制环境噪声。针对二阶统计量,可以设计一个多通道维纳滤波器(MWF)以降低噪声。MWF的噪声抑制性能依赖于参考麦克风的选择和语音协方差矩阵的秩,因此,参考麦克风和秩如何影响后续识别的准确度是一个值得研究的问题。在本文中,我们对低秩近似和参考麦克风选择进行了实验研究,并将其应用于带噪语音识别。此外,本文还提出了最大化输入信噪比的方法以提升信号质量。实验结果表明,秩1 MWF的输出信噪比与参考麦克风无关,语音可懂度始终与秩和参考麦克风有关,词错误率与秩呈正相关,本文提出的参考麦克风选择方法可以同时提高语音可懂度并降低词错误率。

3. An Iteratvie Fine-tuning Approach to Neural Network Pruning for Designing Compact Audio-visual Wake Word Spotting Systems

论文作者:周恒顺,杜俊, Chao-Han Huck Yang,熊世富,李锦辉

论文单位:中国科学技术大学,科大讯飞,佐治亚理工学院

论文简介:

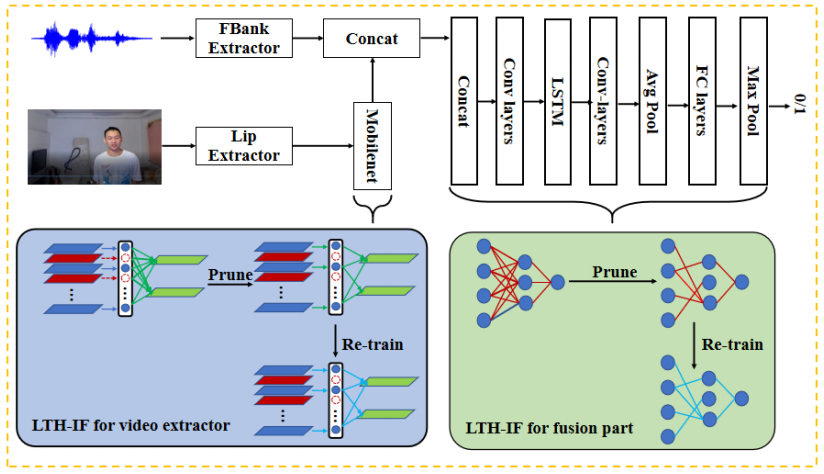

在本文中,我们提出了一个音视频唤醒词识别(Audio-visual wake word spotting,AVWWS)框架,该框架利用视觉信息补充单模态音频输入,以减少单模态语音交互中潜在噪声干扰导致的系统性能下降。具体来说,我们使用MobileNet将检测到人脸中的嘴唇编码为固定尺寸的向量,并将它们与提取的声学特征向量做拼接,然后送入一个融合网络进行判决。为了缓解使用音视频神经网络模型在轻量化实施中的计算复杂性问题,我们提出了一种基于彩票假设(Lottery ticket hypothesis,LTH)的迭代微调(LTH-IF)神经网络剪枝策略,并将其应用到单模态和多模态模型。在一个家居环境下录制的音视频唤醒内部语料库上进行了测试,提出的多模态框架在不同噪声条件下比单模态系统均实现了显著的性能改进。此外,LTH-IF可以在不降低唤醒性能的情况下大幅剪枝网络参数和降低计算量,从而为电视唤醒场景提供潜在的产品解决方案。

4. A Time Domain Progressive Learning Approach with SNR Constriction for Single-Channel Speech Enhancement and Recognition

论文作者:念朝旭,杜俊,杨宇庭,王仁宇

论文单位:中国科学技术大学,华为诺亚实验室

论文简介:

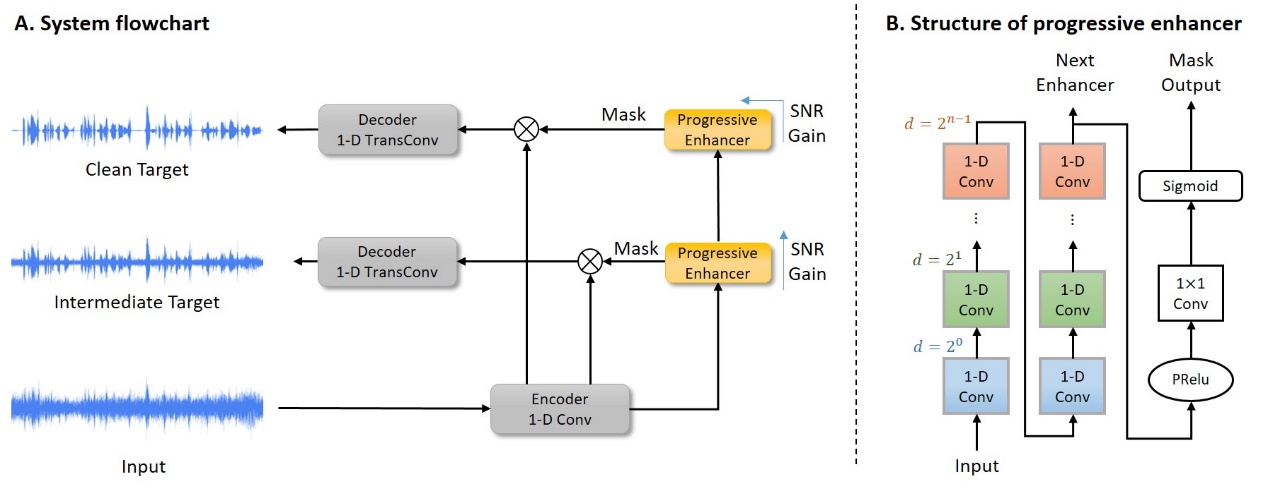

针对自动语音识别的单通道语音增强已经得到了广泛的研究。然而,大多数语音增强方法导致过度抑制并引入失真,这限制了性能增益甚至恶化了识别性能。解决这个问题的关键是在抑制背景噪声的同时保持语音的完整性。因此,我们提出了一种时域渐进学习(TDPL)方法用于语音增强和语音识别。TDPL模型由编码器、渐进增强器和解码器组成。同时学习了信噪比提高、语音失真较小的中间目标和收听质量/清晰度较好的干净目标,分别用于语音识别预处理和语音通信。此外,我们还提出了一个适合TDPL的信噪比受限损失,以进一步提高系统性能。我们在CHiME-4真实评估集上评估了所提出的方法。结果表明,在ASR任务中,TDPL方法明显优于时域语音增强方法和频域渐进学习方法,TDPL的中间输出在强大的ASR后端下实现了36.3%的相对词错误率降低。此外,在PESQ和STOI度量方面,估计的干净输出在CHiME-4模拟评估集上实现了一定的改进。

5. The Prototype Co-prime Array with a Robust Difference Co-array

论文作者:沙兰, 杜俊

论文单位:中国科学技术大学

论文简介:

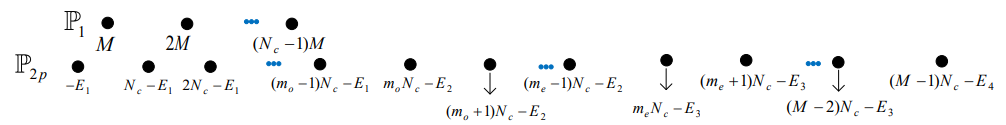

在本文中,我们提出了一种新的稀疏共质阵列设计,可以实现更高的波达方向(DOA)估计自由度(DOF)。提出的阵列设计采用了一系列位移,以系统的方式应用于传统共质数阵列(ProCA)的一个子阵列天线。应用的位移完全消除了两个子阵列之间的冗余虚拟天线,同时大大增加了它们的平均自由度。此外,在没有交叉天线冗余的情况下,提出的方法具有理想的第一权重函数,因此,在存在互耦的情况下,它比其他共质数阵列设计更可靠地解析源。仿真结果表明,所提出的共质数阵列设计具有优越的性能。

6. Improving Separation-based Speaker Diarization via Iterative Model Refinement and Speaker Embedding based Post-processing

论文作者:牛树同,杜俊,孙磊,李锦辉

论文单位:中国科学技术大学,科大讯飞,佐治亚理工学院

论文简介:

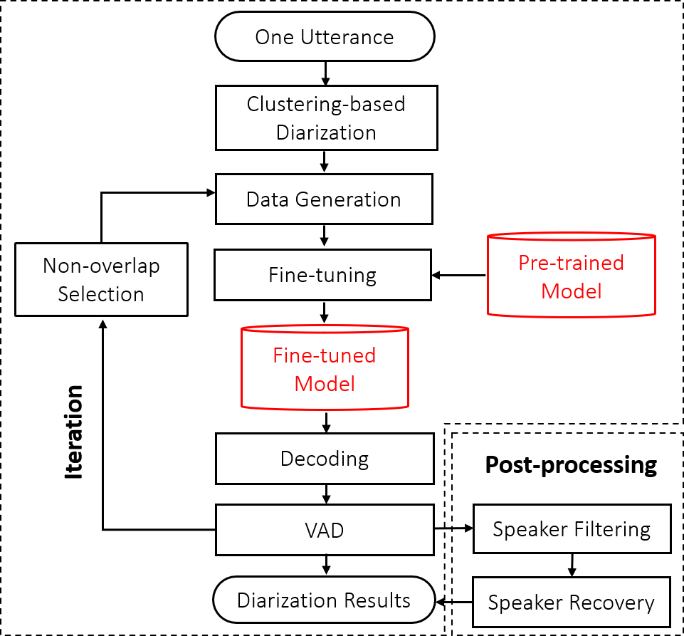

在本文中,我们提出了一种迭代的基于语音分离的说话人日志(Iterative separation-based speaker diarization,ISSD)框架,用于处理真实的语音数据。在我们提出的ISSD框架中,我们根据说话人先验迭代地产生自适应数据来微调分离模型,这种方法可以使得模型的性能逐渐提升。为了减少在简单的ISSD框架中由于不可避免的先验错误造成的检测误差,我们利用声纹信息提出了两种后处理的技术,即说话人过滤(Speaker filtering)和说话人恢复(Speaker recovery)。我们在DIHARD-III挑战的两说话人电话数据(CTS)中测试了提出方法的性能。当和最先进的基于聚类的说话人日志系统比较时,我们提出的结合了两种后处理技术的ISSD方法在开发集和测试集上分别降低了47.72%和46.97%的相对错误率。ISSD也是我们在DIHARD-III挑战的冠军系统中做出的一个重要贡献。

7. Discourse-Level Prosody Modeling with a Variational Autoencoder for Non-Autoregressive Expressive Speech Synthesis

论文作者:吴宁谦,刘朝辞,凌震华

论文单位:中国科学技术大学

论文简介:

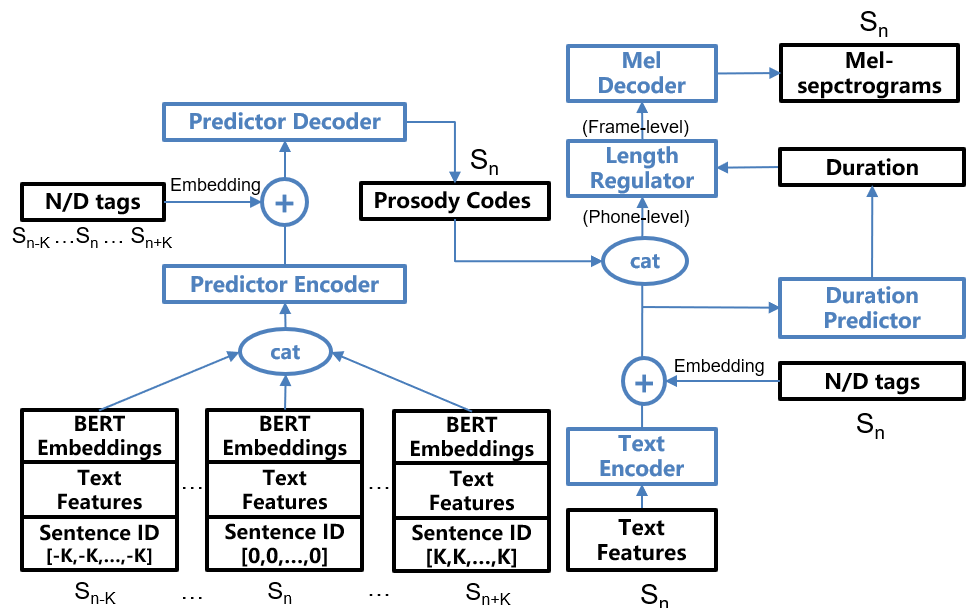

在高表现力语音合成任务中,音素序列到声学特征序列的一对多映射现象是一个关键问题。针对该问题,论文提出了一种基于变分自编码器(VAE)与非自回归语音合成模型FastSpeech的篇章级韵律建模方法。该方法在FastSpeech框架中引入VAE抽取音素级韵律编码,并通过篇章级的文本特征与BERT特征对韵律编码进行预测。论文在汉语有声小说数据集上的实验表明,该方法能有效利用篇章级别的文本信息,合成的语音在自然度和表现力上都超过了基线FastSpeech2模型。

论文资源:Demo语音网页http://home.ustc.edu.cn/~wunq/DLFS/demo.html(或扫描下方二维码)

8. Improving Recognition-Synthesis Based Any-to-One Voice Conversion with Cyclic Training

论文作者:陈言年、刘利娟、胡亚军、江源、凌震华

论文单位:中国科学技术大学,科大讯飞

论文简介:

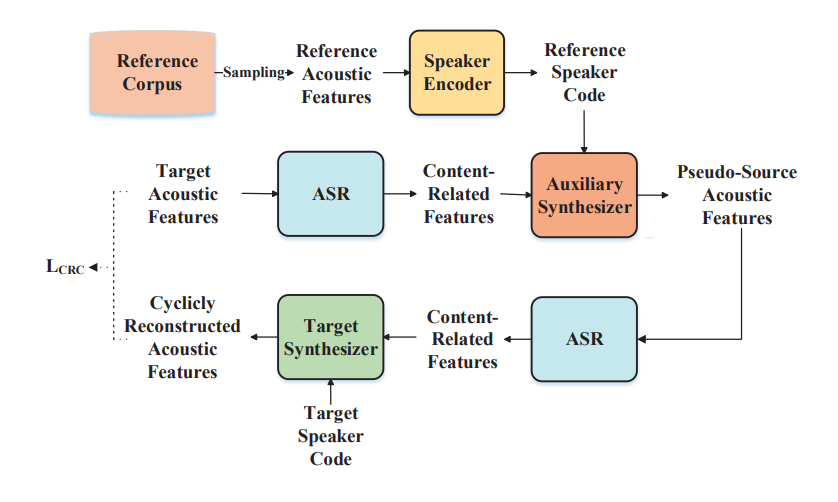

在基于识别-合成框架下的任意说话人到目标说话人的声音转换 (any-to-one VC) 中,识别模型提取的内容相关特征残留一部分说话人信息,而合成模型在训练时输入目标说话人语音的内容相关特征,在测试阶段输入源说话人语音的。这存在训练测试不匹配问题,源说话人内容相关特征中的说话人信息会影响转换后和目标说话人的相似度。本文提出一种cyclic training训练方式,通过引入辅助合成模型,在训练时以目标说话人语音的内容相关特征为输入,从多说话人数据库里采样语音提取说话人信息表征,生成和目标说话人语音文本结构一致,说话人风格不一致且风格多样的“伪源”语音。再将“伪源”语音的内容相关信息输入目标合成模型重构目标的原始语音,以cyclic reconstruction loss作为准则训练目标合成模型。实验表明:本文提出的方法在输入不同源说话人的语音时,比现有的识别-合成基线模型取得更为一致的转换效果;并进一步提升了现有的识别-合成模型的转换相似度,尤其当源和目标说话人风格差别较大时,效果提升十分显著。

论文资源:Demo语音网页https://nian2932491631.github.io/CycleRecSynVC/ (或扫描下方二维码)

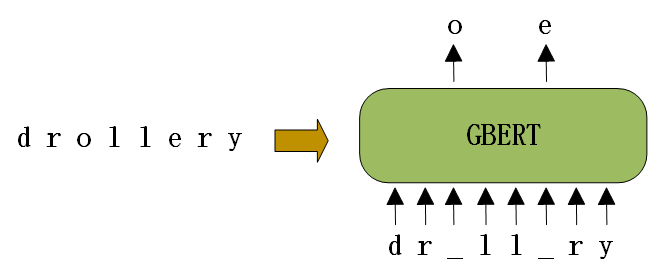

9. Neural Grapheme-to-Phoneme Conversion with Pre-trained Grapheme Models

论文作者:董璐,郭志强,谭超鸿,胡亚军,江源,凌震华

论文单位:中国科学技术大学,科大讯飞

论文简介:

神经网络模型已经在字素到音素转换(G2P)任务上取得了最先进的性能。然而,神经网络的性能非常依赖于大规模的发音词典,而很多语言的大型发音词典往往很难构建。受到预训练语言模型BERT的启发,本文提出了一种预训练字素模型称为字素BERT(GraphemeBERT, GBERT),GBERT通过在特定语言的只含字素信息的单词列表上面进行自监督训练得到。此外,本文还开发了两种方法将GBERT 整合到基于 Transformer 的G2P 模型中,即微调GBERT和通过注意力机制将GBERT融合到Transformer 模型。在SIGMORPHON 2021 G2P任务的荷兰语、塞尔维亚-克罗地亚语、保加利亚语和韩语数据集的结果表明,基于GBERT的G2P模型在中等资源和低资源数据条件都可以显著改善G2P的准确率。

论文资源:论文预印版下载地址http://arxiv.org/abs/2201.10716(或扫描下方二维码)

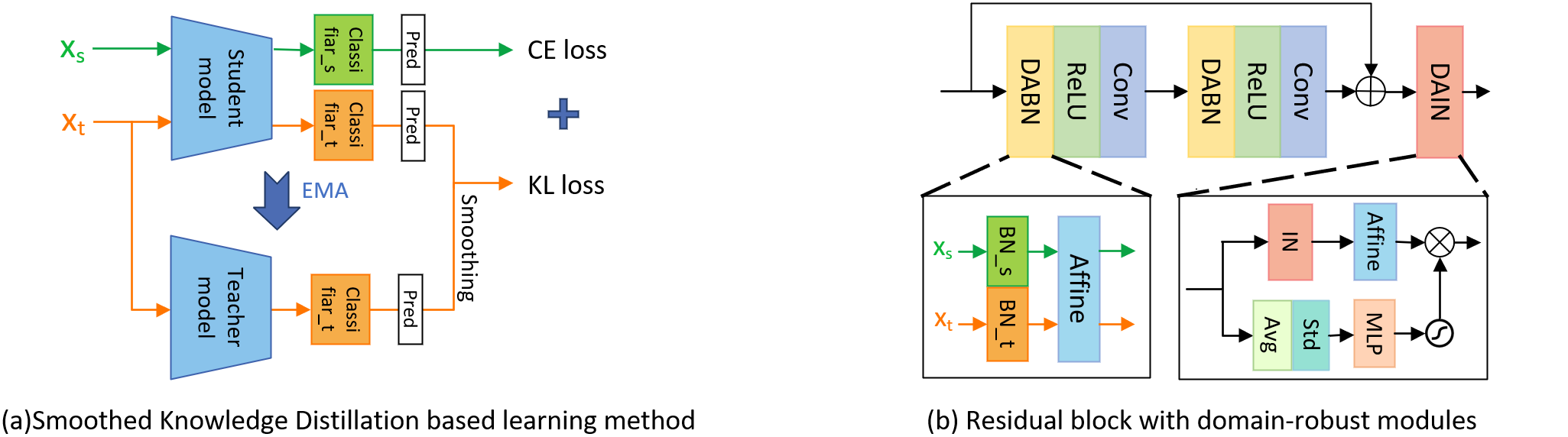

10. Domain robust deep embedding learning for speaker recognition

论文作者:胡航瑞,宋彦,刘颖,戴礼荣,Ian McLoughlin,柳林

论文单位:中国科学技术大学,新加坡理工大学,科大讯飞

论文简介:

本文提出了一种域鲁棒的的说话人深度特征学习方法。随着深度学习的发展,最新的方法主要利用深度神经网络来从大规模的标记数据集(例如VoxCeleb和NIST SRE语料库)中学习紧凑的说话人特征表示,并在说话人验证任务中取得了巨大成功。但是,当这些方法应用在新的目标数据集上进行测试时,往往会出现严重的性能下降,这主要是由于训练域和测试域之间的分布存在着较大差异。此外,由于语料的采样环境以及语种的不同,导致同一个域内也可能存在多个分布不匹配的潜在子域。为了解决上述问题,本文提出了一个多任务的端到端框架,旨在从有标签的源域数据集和无标签的目标域数据集中共同学习说话人深层特征表示。受标签平滑的启发,本文设计了一种基于平滑知识蒸馏的自监督学习方法,以发掘无标签目标域的潜在结构信息。此外,本文还提出了域已知的批量归一化 (DABN) 模块用以减小域间的分布差异,和域未知的实例归一化 (DAIN) 模块用以减轻域内潜在子域的不匹配程度。所提方法在NIST SRE16上进行了实验并取得了显著的性能提升。

11. Frontend attributes disentanglement for speech emotion recognition

论文作者:奚宇轩,宋彦,戴礼荣,Ian McLoughlin,柳林

论文单位:中国科学技术大学,新加坡理工大学,科大讯飞

论文简介

在小数据集上进行语音情感识别(SER)是一项具有挑战性的任务,因为除了情感之外,语音还包含各种无关属性,包括说话人、内容和语种。由于说话人属性和情感属性之间的密切关系,从预先训练的说话人识别(SR)前端提取的特征(i-vector和x-vector)进行简单地微调,就足以获得良好的SER性能。在本文中,我们的目标是使用预先训练好的SR模型对SER任务执行前端属性分离(AD)。我们提出的AD模块包括属性标准化(AN)阶段和属性重建(AR)阶段。AN阶段使用实例归一化(IN)过滤出属性信息,AR阶段从剩余特征中重构情感相关特征,以确保情感辨别能力。为了更好地分离两种属性,我们设计了一个双重空间损失,从而达成情感相关空间和情感无关空间的可分性。为了引入用于情感相关信息重建的上下文信息,我们进一步提出了时频注意力机制(TF-attention)。与以往工作中对提取的x-vector进行风格分离不同,本文提出的AD模块可以应用于前端特征的属性分离。在IEMOCAP基准上的实验证明了该方法的有效性。

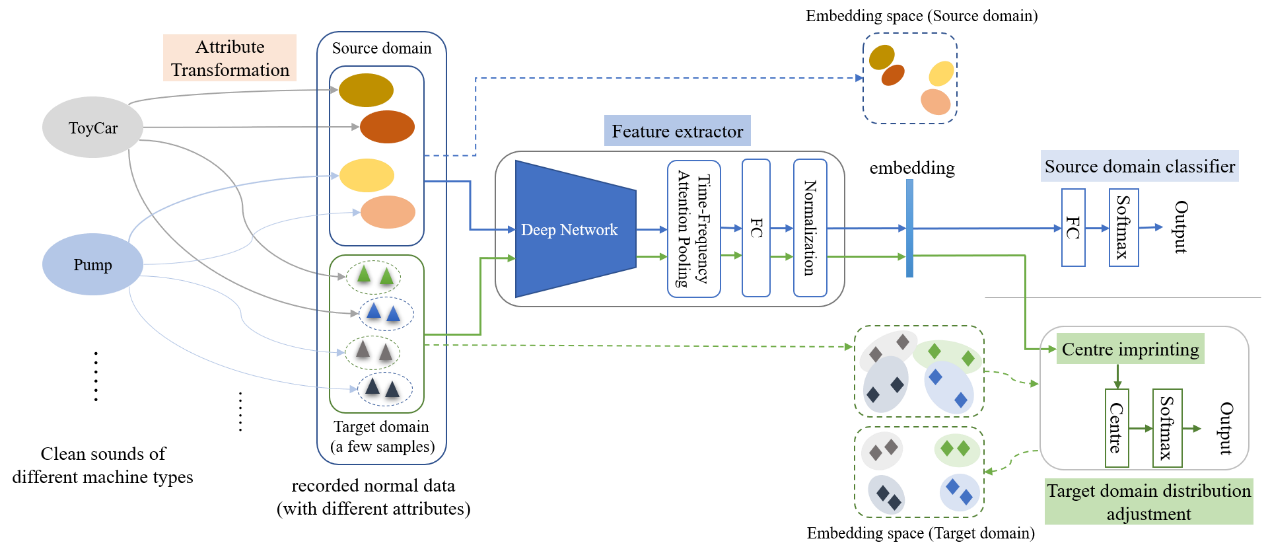

12. Self-Supervised Representation Learning for Unsupervised Anomalous Sound Detection under Domain Shift

论文作者:陈晗,宋彦,戴礼荣,马国岭,柳林

论文单位:中国科学技术大学,科大讯飞

论文简介:

本文提出了一种用于异常声音检测的自监督表达学习方法。异常声音检测近来在声学场景社区中受到了很多研究关注,其目标是在只提供正常训练样本的条件下判断机器发出的声音是否为异常的。这是一项具有挑战性的任务,因为不同类型机器的声音具有高度变化的时频特性,正常声音多样化的属性变动也增加了检测异常的难度。对于域偏移任务来说尤其如此,因为只有极少量训练样本可用。从自监督学习的角度来看,每个给定的声音片段可以被视为原始干净声音的一种变换,每个片段的属性则指示不同的监督信号。我们提出了一个统一的配备时频注意力机制的表达学习框架来对不同的机器类型和属性执行异常检测。针对域偏移,提出了一种代理中心确定方法,其直接为目标域属性设置类中心,提供了即时有效的表达和用于进一步微调的良好初始化。

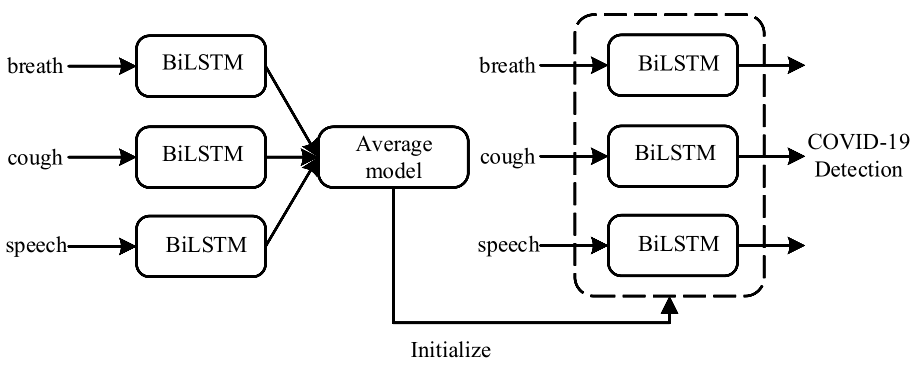

13. Supervised and Self-supervised Pretraining Based COVID-19 Detection Using Acoustic Breathing/Cough/Speech Signals

论文作者:陈星宇,朱秋实,张结,戴礼荣

论文单位:中国科学技术大学,中科院声学所国家重点实验室

论文简介:

在这项工作中,我们提出了一种使用呼吸声、说话声和咳嗽声的基于双向长短时记忆网络的COVID-19检测方法。通过不同的声学信号分别训练网络,我们可以为三个任务建立单独的模型,将其模型参数权重平均得到一个平均模型,然后将其为每个任务的模型做初始化。这种初始化方法可以显著提高三个任务的性能,超过了官方的基线结果。此外,我们还利用公开预训练模型wav2vec2.0模型并使用官方DiCOVA数据集对其进行预训练。该wav2vec2.0模型用于提取音频的高维表征作为模型输入,以代替传统的梅尔频率倒谱特征。实验结果表明,将高维特征和梅尔频率倒谱特征结合使用可以提高性能。为了进一步提高模型性能,我们还采用了一些预处理技术,比如切除无声片段,幅度归一化和频谱增强。提出的模型在DiCOVA数据集上进行评估,结果表明我们的方法在融合赛道的盲测数据集上AUC达到了88.44%。

论文资源:论文预印版下载地址https://arxiv.org/abs/2201.08934(或扫描下方二维码)

14. Dementia Detection by Fusing Speech and Eye-tracking Representation

论文作者:盛峥彦,郭志强,李鑫,李云霞,凌震华

论文单位:中国科学技术大学,科大讯飞,上海同济医院

论文简介:

本文提出了一种融合语音和眼动信息进行痴呆检测的方法。首先,采用语音识别和区域图像识别模型提取受试者在图片描述任务中的语音和眼动的瓶颈特征。接着,采用深度学习融合两种模态的特征来判别痴呆患者和健康人群,包括用于特征融合的跨模态Transformer和最终分类的自注意力Transformer。实验结果表明,提出的方法在痴呆检测任务上达到84.26%的准确率,高于单模态的基线检测方法。

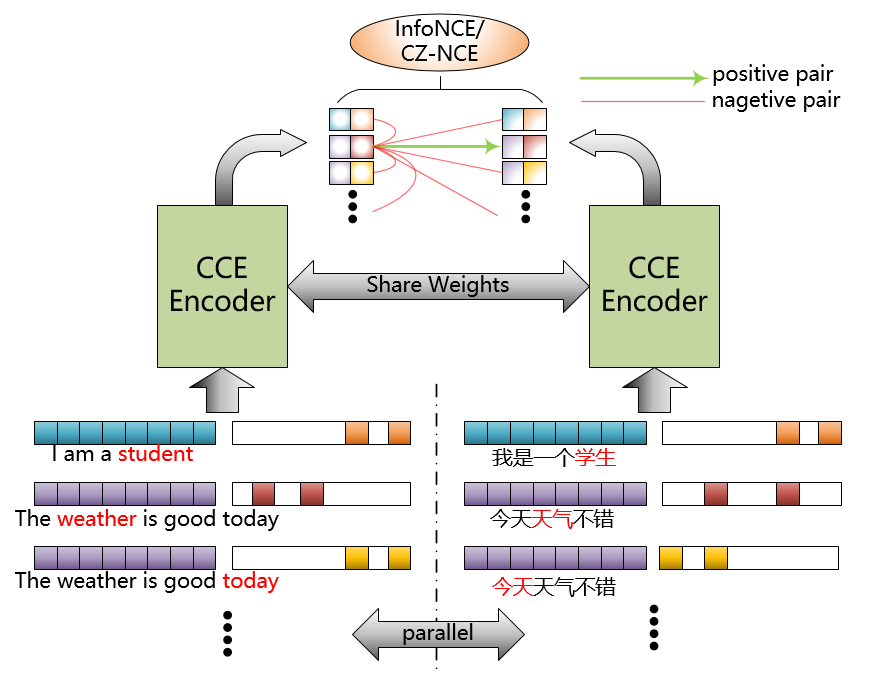

15. Multi-Level Contrastive Learning for Cross-Lingual Alignment

论文作者:陈贝多,郭武,古斌,刘权

论文单位:中国科学技术大学,科大讯飞

论文简介:

预训练模型(如mBert)可以对下游的自然语言处理任务提供巨大的性能提升,在本文中,我们在预训练模型的基础上提出一种多层次的对比学习的方法进一步来提升性能。具体而言,就是使用翻译的平行语对来训练模型学习不同语言下的语义表达,与以前仅仅采用句子一级的方法不同之处在于我们把字颗粒度的信息也融入到模型训练中。进一步为了减少神经网络训练中小数据包情况下的浮点错误,我们提出了过零的对比估计损失函数(CZ-NCE). 提出的方法显著的改进了mBert的跨语言学习能力,在很多零资源学习的下游任务上取得了明显的性能提升。