2021年10月11日,CCF A类国际顶级会议-国际计算机视觉大会(以下简称ICCV 2021)主办的戴口罩人脸识别研讨会(以下称“ICCV 2021 Masked Face Recognition Challenge & Workshop ”)举行了颁奖典礼。由来自中国科学技术大学信息学院自动化系和语音及语言信息处理国家工程实验室语音情感计算及多模态交互研究室组成的参赛团队(以下简称USTC-NELSLIP参赛团队)斩获最佳论文Runner-Up奖。团队工作由於俊副教授等指导研究生郝鑫龙、崔泽宇和贺鹏来完成。

ICCV 由电气与电子工程师协会(IEEE)主办,是计算机视觉领域最重要和权威的国际顶级会议(网址:http://iccv2021.thecvf.com/),被澳大利亚ICT学术会议排名和中国计算机学会等机构评为最高级别学术会议,在业内具有极高的评价。

在 COVID-19 冠状病毒流行期间,几乎每个人都戴着口罩,这对人脸识别提出了巨大挑战。传统的人脸识别系统可能无法有效识别蒙面人脸,但摘下口罩进行身份验证会增加病毒感染的风险。因此,人们在公共场所戴防护口罩的广泛要求促使人脸识别技术需要了解如何处理被遮挡的面部,这些面部通常只有眼周区域和上方可见。针对这一现实场景,在该会议上举办的“Masked Face Recognition Challenge & Workshop ICCV 2021”(网址:https://ibug.doc.ic.ac.uk/resources/masked-face-recognition-challenge-workshop-iccv-21/)收集了各个人种的戴口罩人脸并专注于在口罩存在下对人脸识别方法进行基准测试。

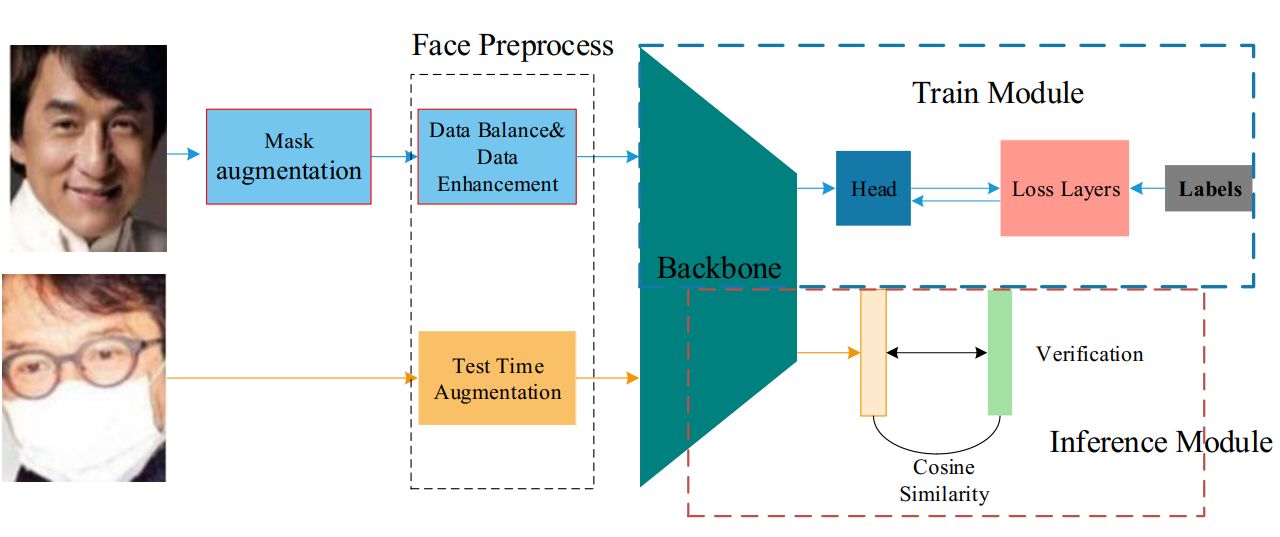

解决方案流程图

我方论文主要使用了口罩人脸数据增强、数据平衡和非对称损失函数三种技术,从而获得了公平和高精度的口罩人脸识别结果。解决方案流程主要由三部分组成,分别是口罩人脸数据增强、人脸预处理、训练模块和推理模块。

在清理InsightFace原始训练数据集的基础上,对于包含普通人脸图像以及戴口罩人脸图像的测试数据集的评估,我们主要使用TAR以及FAR的测评方式,同时口罩人脸数据的TAR指标以及不同人种人脸识别率之间的偏差Bias是我们最关注的两个指标。

对于口罩人脸数据增强,利用了一种用于给普通人脸图像添加口罩的方法。下图展示了一些没有口罩(左)和有口罩(右)的人脸图像。

口罩增强结果展示

在数据平衡阶段,我们对原始训练数据集使用重采样方法以求得到更为平衡的训练数据。但对于戴口罩人脸数据,嘴巴和鼻子对亚洲人识别率的影响比对其他种族更大,因此口罩会更多地降低亚洲人的识别率,最终我们增加了亚洲人的抽样权重来实现更充分的数据平衡。

对于数据增强来说,在训练阶段,我们使用了多种增强方法来提高数据的多样性;在测试阶段,我们使用一系列测试数据增强方法来获得更加鲁棒的特征。比如我们将原始人脸和水平翻转后的人脸分别输入网络中,然后将两个输出的特征向量加在一起以产生最终的特征向量。

在训练模块中,我们主要使用Arcface的结构,同时还提出了用于训练的非对称损失,具体包含Arcface Loss和Circle Loss,病情对于这两种损失进行组合以同时利用它们的优点。此外,还使用Focal Loss来平衡正负样本。在推理模块中,我们通过计算两个特征向量之间的余弦相似度得到最终的预测值。

本次研讨会吸引了包括微软研究院、阿里巴巴、商汤科技、神目科技、Kakao Enterprise、清华大学、中国科学技术大学、中国科学院大学等国内外著名研究机构在内的200余支队伍参与,经过竞争十分激烈的论文评选, USTC-NELSLIP团队最终荣获了最佳论文Runner-Up奖。

本次参会得到了国家自然科学基金联合基金、安徽省重点研发计划、中国科学技术大学探索类基金等项目的支持。